Контроллер СХД

Контроллер системы (storage controller, он же управляющий узел или node) является главным управляющим компонентом СХД. Он представляет уровень обработки данных, который отвечает за создание дисковых массивов, расчет контрольных сумм, управление доступом и выполнение других служебных операций.

Контроллер СХД — это функциональный блок, поэтому физически он может быть представлен совершенно разным набором оборудования.

RAID-контроллер

В теории, понятие RAID-контроллера и контроллера СХД часто представляются как тождественные. Это связано с тем, что они оба выполняют свою основную функцию — создают и управляют дисковым массивом. На практике же под RAID-контроллером часто подразумевают адаптер, который вставляется в сервер и создает массив из подключенных накопителей. В таком случае RAID-контроллер создает подсистему хранения данных для конкретного локального клиента (инициатора), но не является СХД в ее устоявшемся значении.

Рисунок 8. RAID-контроллер от Microchip.

Контроллер СХД как специализированный компьютер

Если мы говорим о системе хранения данных как о самостоятельной единице инфраструктуры с подключаемыми по сети клиентами, то в этом случае контроллер СХД — это специализированный компьютер с управляющим ПО. Он оснащен материнской платой, центральным процессором и модулями оперативной памяти. Физически такой контроллер может размещаться как в специализированном корпусе, так и в обычном корпусе для монтажа в стойку.

В некоторых решениях управляющее ПО может брать на себя функцию создания RAID-массива из накопителей, что освобождает от необходимости использовать аппаратный RAID-контроллер. Такой механизм часто применяется в программно-определяемых СХД (software-defined storage), у которых контроллер системы может быть реализован на базе стандартных серверных платформ.

Рисунок 9. Supermicro 2029P-E1CR24H — пример стандартной серверной платформы для программно-определяемых СХД.

Двухконтроллерный режим

Системы хранения данных могут быть одноконтроллерные, двухконтроллерные и многоконтроллерные. Последние два варианта используются для повышения производительности, а также повышенной отказоустойчивости: при аппаратном сбое активного контроллера, второй узел «подхватывает» его работу без остановки всей системы.

Рисунок 10. Схема двухконтроллерной СХД на базе RAIDIX.

В двух- и многоконтроллерных конфигурациях узлы соединены каналами связи. Эти каналы могут отличаться в зависимости от архитектуры и функциональных особенностей системы. Например, в классической двухконтроллерной системе на базе RAIDIX это:

- Интерконнект между узлами (Heartbeat) — Ethernet-соединение между узлами для проверки работоспособности контроллеров.

- Синхронизация кэша (Cache sync) — соединение для синхронизации кэша на основе протоколов IB-SRP, iSCSI или SAS.

Стоит отметить, что наличие двух контроллеров не означает использование двух отдельных физических корпусов. Нередко дублирующие материнские платы контроллеров размещаются в разных отсеках внутри одной платформы (рисунок 11).

Рисунок 11. Два контроллера внутри одного серверного корпуса.

Вычислительные ресурсы

С увеличением количества выполняемых функций и используемых накопителей, системе требуется больше вычислительных ресурсов. Например в одноконтроллерной СХД RAIDIX на 60 накопителей для оптимальной производительности требуется 2 восьмиядерных процессора с частотой не ниже 2.1 ГГц и 48 ГБ оперативной памяти, а для системы на 600 дисков требуется 2 восьмиядерных процессора с частотой уже от 3.5 ГГц и более 256 ГБ оперативной памяти.

В качестве процессоров для СХД сейчас в основном используются x86 чипы Intel Xeon и, чуть реже, AMD EPYC. Существуют решения собранные на других процессорах (например, на отечественном Эльбрусе), но они менее популярны на рынке.

Таблица 3. Базовые характеристики серверных процессоров Intel и AMD

| Intel Xeon Scalable | AMD EPYC | |||||

| Bronze | Silver | Gold | Platinum | 1-Socket | 2-Socket | |

| Кол-во сокетов | 1-2 | 1-2 | 2-4 | 2-8 | 1 | 2 |

| Кол-во ядер | 6-8 | 4-12 | 4-22 | 4-28 | 16-32 | 16-32 |

| Базовая частота | 1.7 ГГц | 1.8-2.6 ГГц | 1.9-3.5 ГГц | 2.0-3.6 ГГц | 2.0-2.4 ГГц | 2.0-2.4 ГГц |

| Тип поддерживаемой памяти | DDR4-2133 | DDR4-2400 | DDR4-2666 | DDR4-2666 | DDR4-2666 | DDR4-2666 |

| Кол-во линий PCIe | 48 | 128 |

На объем вычислительных ресурсов в значительной мере влияют установленные бизнес-требования к инфраструктуре хранения, характер и интенсивность нагрузок, а также существующее сетевое окружение.

Хранение данных

Под хранением обычно понимают запись данных на некоторые накопители данных, с целью их (данных) дальнейшего использования. Опустим исторические варианты организации хранения, рассмотрим подробнее классификацию систем хранения по разным критериям. Я выбрал следующие критерии для классификации: по способу подключения, по типу используемых носителей, по форме хранения данных, по реализации.

По способу подключения есть следующие варианты:

подключение дисков в сервере

дисковая полка, подключаемая по FC

По типу используемых накопителей возможно выделить:

- Дисковые. Предельно простой и вероятно наиболее распространенный вариант до сих пор, в качестве накопителей используются жесткие диски

- Ленточные. В качестве накопителей используются запоминающие устройства с носителем на магнитной ленте. Наиболее частое применение — организация резервного копирования.

- Flash. В качестве накопителей применяются твердотельные диски, они же SSD. Наиболее перспективный и быстрый способ организации хранилищ, по емкости SSD уже фактически сравнялись с жесткими дисками (местами и более емкие). Однако по стоимости хранения они все еще дороже.

- Гибридные. Совмещающие в одной системе как жесткие диски, так и SSD. Являются промежуточным вариантом, совмещающим достоинства и недостатки дисковых и flash хранилищ.

Если рассматривать форму хранения данных, то явно выделяются следующие:

- Файлы (именованные области данных). Наиболее популярный тип хранения данных — структура подразумевает хранение данных, одинаковое для пользователя и для накопителя.

- Блоки. Одинаковые по размеру области, при этом структура данных задается пользователем. Характерной особенностью является оптимизация скорости доступа за счет отсутствия слоя преобразования блоки-файлы, присутствующего в предыдущем способе.

- Объекты. Данные хранятся в плоской файловой структуре в виде объектов с метаданными.

По реализации достаточно сложно провести четкие границы, однако можно отметить:

RAID контроллер от компании Fujitsu

пример организации LVM с шифрованием и избыточностью в виртуальной машине Linux в облаке Azure

Давайте рассмотрим более детально некоторые технологии, их достоинства и недостатки.

Дисковый контроллер и бэкплейн

Дисковый контроллер (HBA)

В системах хранения данных дисковый контроллер является устройством, через которое подключенные накопители передаются вычислительным ресурсам системы. Физически дисковый контроллер обычно представлен отдельной картой расширения, но также может быть в виде чипа, интегрированного в непосредственно в материнскую плату. Если говорить простым языком, то дисковый контроллер позволяет видеть и работать с дисками всем следующим уровням СХД.

HBA (Host Bus Adapter, адаптер главной шины) — разновидность дискового контроллера, которая позволяет системе видеть подключенные накопители по отдельности.

Рисунок 5. Дисковый контроллер от Broadcom (9400-8i Tri-Mode Storage Adapter).

Triple-mode

Существуют дисковые контроллеры, которые совмещают в себе возможность одновременной работы сразу с тремя протоколами (SATA, SAS, NVMe). Этот подход удобен и обеспечивает гибкость при проектировании системы хранения, так как позволяет подключать как традиционные SATA-диски, так и сверхбыстрые NVMe накопители.

Бэкплейн и экспандер

В большинстве случаев накопители в СХД подключаются непосредственно через бэкплейн (backplane) — специальную плату в дисковой полке или сервере с разъемами для SAS, SATA, NVMe накопителей, которая соединяется с дисковым контроллером. Сам дисковый контроллер, как правило, поддерживает прямое подключение ограниченного числа накопителей. Для увеличения числа подключаемых дисков используют экспандер. В большинстве случаев он представляет собой чип, который устанавливается на бэкплейн.

Рисунок 6. Бэкплейн Supermicro BPN-SAS-826TQ.

Рисунок 7. SAS-экспандер Broadcom в виде чипа.

Функциональное предназначение

Портативный компьютер (к-р) – это устройство, способное выполнять тот же ряд задач, которые осуществляет настольный компьютер. Однако при условии равной цены, ноутбук будет обладать более низкой производительностью, чем его производственный «оппонент». Ноутбук включает в себя все системы настольного к-ра, но они миниатюризированные и оптимизированные, что позволяет снижать расход энергии при длительном их использовании.

Данная машина также может служить мультимедийным домашним развлекательным центром, устройством. Это можно сделать, например, подключив портативную колонку к компьютеру. «Как это сделать?» – может спросить человек, незнакомый с подобными машинами. Для осуществления этого процесса достаточно взять кабель со штекером, выходящий от колонки и подключить к разъему на корпусе ПК. Как правило, эти «каналы связи» либо выделяются зеленым цветом, либо около них рисуют значок наушников. В силу того, что система подключения и настройки после ввода штекера в разъем, является полностью автоматизированной, дальше достаточно будет отрегулировать громкость самого к-ра.

Общие требования к объему загружаемой системы

Предположим, что необходимо выполнить следующие условия:

- У вас есть устройство хранения, на которое можно установить Windows.

- Сделайте устройство хранения загружаемым.

- Включить операционную систему для решения максимальной емкости хранилища для этого устройства более 2 ТБ.

Для удовлетворения этих условий применяются следующие необходимые условия:

-

Диск необходимо инициализировать с помощью GPT.

-

Прошивка системы должна использовать UEFI.

-

Версия Windows должна быть одной из следующих (только 64-битная, но с учетом всех выпусков SKU):

- Windows Server 2008 R2

- Windows Server 2008

- Windows 7

- Windows Vista

-

Необходимо установить новейшие драйверы хранения от производителя контроллера хранения. Например, если в системе используется контроллер хранения Intel в режиме RAID, убедитесь, что у вас есть последние применимые драйверы на сайте поддержки Intel.

Примечание

Windows не поддерживает запуск инициализированных томов GPT с помощью систем UEFI в 32-битных версиях Windows. Кроме того, устаревшие системы BIOS не поддерживают запуск томов с раздельным GPT. Проконсультируйтесь с поставщиком системы, чтобы определить, поддерживает ли система как UEFI, так и запуск устройств с емкостью хранения более 2 ТБ.

Известные проблемы или ограничения

Так как переход на одноместную емкость более 2 ТБ произошел сравнительно недавно, корпорация Майкрософт исследовала, как Windows поддерживает эти большие диски. В результате выявлено несколько проблем, применимых к всем версиям Windows ранее и включая Windows 7 с Пакет обновления 1 и Windows Server 2008 R2 с Пакет обновления 1.

До этого известно, что при обработке Windows одного диска емкостью более 2 ТБ происходит следующее неправильное поведение:

-

Числовая емкость, превыше 2-х переполнений ТБ. Это приводит к том, что система может решать только возможности, пре превью 2 ТБ. Например, на диске с 3 ТБ доступная емкость может быть только 1 ТБ.

-

Числовая емкость, пре превью 2 ТБ, усечена. Это приводит к не более чем 2 ТБ адресного пространства. Например, на диске с 3 ТБ доступная емкость может быть только 2 ТБ.

-

Устройство хранения обнаружено неправильно. В этом случае он не отображается ни в windows Device Manager, ни в Windows Disk Management. Многие производители контроллеров хранения предлагают обновленные драйверы, которые обеспечивают поддержку емкостей хранения более 2 ТБ. Обратитесь к производителю контроллера хранения или OEM, чтобы определить, какая загружаемая поддержка доступна для однодисковых емкостей с более чем 2 ТБ.

Шаг 2. Настройка сети

если вы развертываете дисковые пространства прямо внутри виртуальных машин, пропустите этот раздел.

дисковые пространства Direct требует сети с высокой пропускной способностью и низкой задержкой между серверами в кластере. Требуется по крайней мере 10 сетей GbE, и рекомендуется использовать удаленный доступ к памяти (RDMA). вы можете использовать либо iWARP, либо роце, если у него есть логотип Windows Server, соответствующий вашей версии операционной системы, но iWARP, как правило, проще в настройке.

Важно!

В зависимости от сетевого оборудования и, особенно с Роце версии 2, может потребоваться настройка коммутатора верхнего уровня. правильная конфигурация коммутатора важна для обеспечения надежности и производительности дисковые пространства Direct.

в Windows Server 2016 введена команда объединения коммутаторов (SET) в виртуальном коммутаторе Hyper-V. Это позволяет использовать одни и те же физические порты сетевого адаптера для всего сетевого трафика при использовании RDMA, уменьшая число необходимых портов физического сетевого адаптера. объединение встроенных коммутаторов рекомендуется для дисковые пространства Direct.

Взаимосвязи узлов с переключением и с переключением

- Переключение: Сетевые коммутаторы должны быть правильно настроены для работы с пропускной способностью и типом сети. Если используется RDMA, который реализует протокол Роце, сетевое устройство и Конфигурация коммутатора еще более важны.

- Без переключения: узлы могут быть взаимосоединены с помощью прямых подключений, избегая использования коммутатора. Необходимо, чтобы каждый узел имел прямое соединение со всеми остальными узлами кластера.

инструкции по настройке сети для дисковые пространства Direct см. в разделе руководств по развертыванию Windows Server 2016 и 2019.

Выбор размера томов

Рекомендуем ограничить размер каждого тома следующим образом:

| Windows Server 2016 | Windows Server 2019 |

|---|---|

| До 32 ТБ | До 64 ТБ |

Совет

Если вы используете решение для резервного копирования, основанное на службе теневого копирования томов (VSS) и в поставщике программного обеспечения Volsnap, как и в случае с рабочими нагрузками файлового сервера, ограничение размера тома до 10 ТБ повысит производительность и надежность. Системы резервного копирования, которые используют новые API RCT Hyper-V, клонирование блоков ReFS или нативные API резервного копирования SQL, хорошо работают на томах размером 32 ТБ и более.

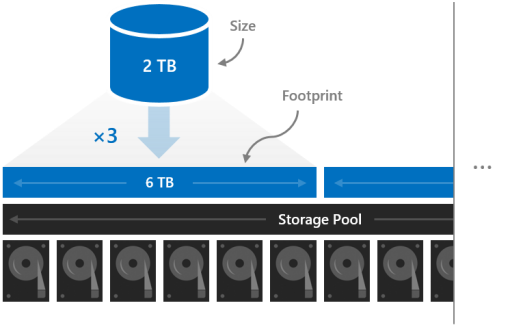

Занимаемое место

Размер тома — это объем данных, которые могут в нем храниться. Он указывается с помощью параметра -Size командлета New-Volume, а затем отображается в свойстве Size при запуске командлета Get-Volume.

Размер отличается от занимаемого места тома — общего объема физической памяти, который он занимает в пуле носителей. Занимаемое место зависит от его типа устойчивости. Например, место, которое занимают тома, использующие трехстороннее зеркальное отображение, в три раза больше их размера.

В пуле носителей должно быть достаточно места для томов.

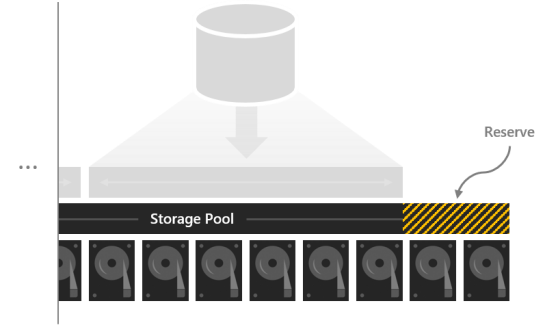

Резервирование емкости

Нераспределенное пространство в пуле носителей повышает производительность и безопасность данных, так как тома могут восстанавливаться «на месте» после сбоя дисков. Если емкости достаточно, тома могут восстановиться «на месте» до состояния полной устойчивости даже до замены отказавших дисков. Это происходит автоматически.

Рекомендуем зарезервировать эквивалент одного диска хранения на сервер (до 4 дисков). Вы можете зарезервировать больше, но эта минимальная емкость гарантирует немедленное параллельное восстановление «на месте» после сбоя любого диска.

Например, если у вас 2 сервера и диски хранения по 1 ТБ, зарезервируйте 2 ТБ в пуле (2 x 1 = 2). Если у вас 3 сервера и диски хранения по 1 ТБ, зарезервируйте 3 ТБ (3 x 1 = 3). Если у вас 4 или больше серверов и диски хранения по 1 ТБ, зарезервируйте 4 ТБ (4 x 1 = 4).

Примечание

В кластерах с дисками всех трех типов (NVMe + SSD + HDD) рекомендуем зарезервировать место, равное суммарному размеру одного SSD и одного HDD на сервер (до 4 дисков в каждом случае).

Сводка

В этом разделе описываются типы устойчивости, доступные в локальных дисковых пространствах, минимальные требования к масштабированию при использовании каждого из этих типов, число допустимых сбоев для каждого из этих типов и соответствующая экономичность хранения.

Типы устойчивости

| Устойчивость | Отказоустойчивость | Экономичность хранения |

|---|---|---|

| Двухстороннее зеркало | 1 | 50.0% |

| Трехстороннее зеркало | 2 | 33,3 % |

| Двойная четность | 2 | 50,0–80,0 % |

| Смешанный | 2 | 33,3–80,0 % |

Минимальные требования к масштабированию

| Устойчивость | Минимальное количество доменов сбоя |

|---|---|

| Двухстороннее зеркало | 2 |

| Трехстороннее зеркало | 3 |

| Двойная четность | 4 |

| Смешанный | 4 |

Совет

Если вы не используете отказоустойчивость на уровне корпуса или стоек, количество доменов сбоя соответствует количеству серверов. Число накопителей в каждом сервере не влияет на то, какие типы устойчивости можно использовать, если выполняются минимальные требования для локальных дисковых пространств.

Эффективность двойной четности для гибридных развертываний

В этой таблице показана экономичность хранения данных при использовании двойной четности и локальных кодов реконструкции в каждом масштабе для гибридных развертываний с применением жестких дисков (HDD) и твердотельных накопителей (SSD).

| Домены сбоя | Layout | Эффективность |

|---|---|---|

| 2 | – | – |

| 3 | – | – |

| 4 | RS 2+2 | 50.0% |

| 5 | RS 2+2 | 50.0% |

| 6 | RS 2+2 | 50.0% |

| 7 | RS 4+2 | 66,7 % |

| 8 | RS 4+2 | 66,7 % |

| 9 | RS 4+2 | 66,7 % |

| 10 | RS 4+2 | 66,7 % |

| 11 | RS 4+2 | 66,7 % |

| 12 | LRC (8, 2, 1) | 72,7 % |

| 13 | LRC (8, 2, 1) | 72,7 % |

| 14 | LRC (8, 2, 1) | 72,7 % |

| 15 | LRC (8, 2, 1) | 72,7 % |

| 16 | LRC (8, 2, 1) | 72,7 % |

Эффективность двойной четности для развертываний с применением только флэш-накопителей

В этой таблице показана экономичность хранения данных при использовании двойной четности и локальных кодов реконструкции в каждом масштабе для развертываний с применением только флэш-накопителей, в которых используются только твердотельные накопители (SSD). Структура с контролем четности может использовать более крупные размеры групп и обеспечивать лучшую экономичность хранения в конфигурации с применением только флэш-накопителей.

| Домены сбоя | Layout | Эффективность |

|---|---|---|

| 2 | – | – |

| 3 | – | – |

| 4 | RS 2+2 | 50.0% |

| 5 | RS 2+2 | 50.0% |

| 6 | RS 2+2 | 50.0% |

| 7 | RS 4+2 | 66,7 % |

| 8 | RS 4+2 | 66,7 % |

| 9 | RS 6+2 | 75.0% |

| 10 | RS 6+2 | 75.0% |

| 11 | RS 6+2 | 75.0% |

| 12 | RS 6+2 | 75.0% |

| 13 | RS 6+2 | 75.0% |

| 14 | RS 6+2 | 75.0% |

| 15 | RS 6+2 | 75.0% |

| 16 | LRC (12, 2, 1) | 80 % |

Облака и эфемерные хранилища

Логическим продолжением перехода на виртуализацию является запуск сервисов в облаках. В предельном случае сервисы разбиваются на функции, запускаемые по требованию (бессерверные вычисления, serverless)

Важной особенностью тут является отсутствие состояния, то есть сервисы запускаются по требованию и потенциально могут быть запущены столько экземпляров приложения, сколько требуется для текущей нагрузки. Большинство поставщиков (GCP, Azure, Amazon и прочие) облачных решений предлагают также и доступ к хранилищам, включая файловые и блочные, а также объектные

Некоторые предлагают дополнительно облачные базы, так что приложение, рассчитанное на запуск в таком облаке, легко может работать с подобными системами хранения данных. Для того, чтобы все работало, достаточно оплатить вовремя эти услуги, для небольших приложений поставщики вообще предлагают бесплатное использование ресурсов в течение некоторого срока, либо вообще навсегда.

Из недостатков: могут заблокировать аккаунт, на котором все работает, что может привести к простоям в работе. Также могут быть проблемы со связностью и\или доступностью таких сервисов по сети, поскольку такие хранилища полностью зависят от корректной и правильной работы глобальной сети.

Сеть

дисковые пространства Direct требует надежного подключения с высокой пропускной способностью и низкой задержкой между каждым узлом.

Минимальное количество соединений для узла малого масштаба 2-3

- 10 Гбит/с сетевая карта (NIC) или более мощный

- Два или более сетевых подключения для каждого узла, Рекомендуемые для избыточности и производительности.

Рекомендуемое соединение для высокопроизводительных, масштабируемых или развертываний 4 +

- Сетевые карты, поддерживающие удаленный доступ к памяти (RDMA), iWARP (рекомендуется) или Роце

- Два или более сетевых подключения для каждого узла, Рекомендуемые для избыточности и производительности.

- 25 Гбит/с, сетевой адаптер или более мощный

Взаимосвязи узлов с переключением и с переключением

- Переключение: Сетевые коммутаторы должны быть правильно настроены для работы с пропускной способностью и типом сети. Если используется RDMA, который реализует протокол Роце, сетевое устройство и Конфигурация коммутатора еще более важны.

- Без переключения: узлы могут быть взаимосоединены с помощью прямых подключений, избегая использования коммутатора. Необходимо, чтобы каждый узел имел прямое соединение со всеми остальными узлами кластера.

Chapter 3: Connecting to the SmartStor

•Setting up a Network Drive on a Windows PC (page 19)

•Setting up a Network Drive on a UNIX or Linux PC (page 22)

•Setting up a Network Drive on a Macintosh PC (page 26)

•Connecting a USB Printer to SmartStor (page 29)

•Setting up the Print Server on SmartStor (page 30)

•Setting up Windows Printing (page 30)

•Setting up Linux Printing (page 32)

•Setting up Macintosh Printing (page 35)

•Connecting a USB Drive (page 37)

•Disconnecting a USB Drive (page 40)

•Setting-up Apple iTunes (page 40)

To copy files to and from a folder on the SmartStor, you must make the folder a network drive on your PC.

To use the SmartStor as a print server, you must connect the USB printer, enable SmartStor’s print server, and set up printing on your PC.

Setting up a Network Drive on a Windows PC

You can also use SmartNAVI for this purpose, see “Mounting a Share Folder / Creating a Network Drive” on page 72. If your PC does not have SmartNAVI, use the following procedure to setup a Network Drive with My Network Places.

Using the SMB protocol, SmartStor supports up to 16 concurrent connections.

To setup a network drive:

1.On the Windows desktop, double-click the My Network Places icon.

2.Click the Search button in the toolbar.

If the Search button is not shown, from the View menu, choose Toolbars, then Standard Buttons.

Развертывание сетей хранения данных с отказоустойчивыми кластерами

При развертывании сети хранения данных (SAN) с отказоустойчивым кластером руководствуйтесь следующими рекомендациями.

Подтвердите совместимость хранилища. Обратитесь к производителям и поставщикам, чтобы подтвердить, что хранилище, включая драйверы, встроенное ПО и ПО, используемое для хранилища, совместимо с отказоустойчивыми кластерами в используемой версии Windows Server.

Изолируйте запоминающие устройства по одному кластеру на устройство: серверы из различных кластеров не должны иметь доступа к одним и тем же запоминающим устройствам. В большинстве случаев LUN, используемый для одного набора серверов кластера, должен быть изолирован от всех остальных серверов с помощью маски или зонирования LUN.

Рассмотрите использование ПО многоканального ввода-вывода или сетевых адаптеров с поддержкой совместной работы: в архитектуре хранилищ с высокой доступностью можно развернуть отказоустойчивые кластеры с несколькими адаптерами шины, используя ПО многоканального ввода-вывода или сетевых адаптеров с поддержкой совместной работы (что также называется отказоустойчивой балансировкой нагрузки — LBFO). Это обеспечивает максимальный уровень резервирования и доступности. для Windows Server 2012 R2 или Windows Server 2012 решение multipath должно быть основано на Microsoft Multipath I/O (MPIO). Поставщики оборудования обычно предоставляют модуль MPIO для конкретного устройства (DSM), но в комплект поставки операционной системы Windows Server также входят один или несколько модулей DSM.

дополнительные сведения о LBFO см

в статье обзор объединения сетевых карт в технической библиотеке Windows Server.

Важно!

Некоторые адаптеры шины и программное обеспечение многоканального ввода-вывода сильно зависят от версий. При реализации многоканального решения для кластера следует проконсультироваться с поставщиком оборудования, чтобы выбрать правильные адаптеры, встроенное программное обеспечение и программное обеспечение для используемой версии Windows Server.

рассмотрите возможность использования дисковые пространства

если планируется развертывание кластеризованного хранилища serial attached SCSI (SAS), настроенного с помощью дисковые пространства, см. раздел развертывание кластерных дисковые пространства для требований.

Имена недействительных файлов

Папки или файлы, содержащие недействительные или зарезервированные имена файлов, также могут быть исключены из статистики файлов и папок. В NTFS допустимы папки или файлы, содержащие ведущие или точки заднего пользования, но они не допустимы с точки зрения подсистемы Win32. Поэтому ни Windows, ни командная подсказка не могут надежно работать с ними.

Возможно, вы не сможете переименовать или удалить эти файлы или папки. При попытке сделать это вы можете получить одно из следующих сообщений об ошибке:

или

Если у вас есть папки или файлы, которые нельзя удалить или переименовать, обратитесь в службы поддержки продуктов Майкрософт.

Заключение

Базовая задача сетевого хранилища — хранение пользовательских данных и обеспечение доступа к ним. Но, как мы показали в статье, возможности современных NAS намного шире. Благодаря установке пакетов сетевое хранилище превращается в мультимедийный сервер, станцию видеонаблюдения, частное облако, средство коллективной работы и т.д. NAS обеспечивает комплекс услуг, которые оказываются весьма полезны в условиях как дома, так и малого офиса.

Мы рассмотрели и характеристики, на которые следует обращать внимание при выборе NAS: число отсеков и емкость дисков, производительность, интерфейсы, подключение к локальной сети, оптимальные жесткие диски, энергопотребление. Будем надеяться, что наша статья поможет выбрать наиболее подходящее сетевое хранилище для ваших задач

Ниже мы приведем две рекомендации, в зависимости от доступного бюджета. Они не являются исчерпывающими, поскольку на рынке есть и другие весьма достойные модели NAS

Будем надеяться, что наша статья поможет выбрать наиболее подходящее сетевое хранилище для ваших задач. Ниже мы приведем две рекомендации, в зависимости от доступного бюджета. Они не являются исчерпывающими, поскольку на рынке есть и другие весьма достойные модели NAS.

Базовый уровень. Synology DS420j (четыре отсека) или DS220j (два отсека). Два бюджетных NAS на 4-ядерном процессоре ARM. Имеют всего 512 Мбайт/1 Гбайт памяти без возможности расширения. Можно покупать, если планируется только хранение файлов и пара дополнительных сервисов. Производительность чтения/записи будет файлов на уровне интерфейса 1 Гбит/с, но дополнительные сервисы уже могут «подтормаживать».